„Als Vorgesetzter muss man in der Lage sein, dem Sparzwang widerstehen zu können“

Man hört ja seit Jahren immer wieder das Credo „Safety by Design“: die Funktionsfähigkeit, die Systemsicherheit muss von Anfang an Grundbestandteil des Software Designs sein. Was natürlich ausschließen würde, dass man dann im Nachgang sicherheitskritische Elemente nochmal aufmacht und neue Codezeilen dazu packt. Aber dann hört man auf der anderen Seite, dass Zeitdruck, Kostendruck und Time-to-Market mit diesen Ansprüchen in Konflikt stehen.

Bestehende komplexe Software, die man aufmachen muss, um hinterher neue Funktionen drauf zu setzen, ist ja nicht unbedingt ungewöhnlich. Vor allem, wenn es nach früheren rudimentären Methoden entwickelt wurde, wo auch die Dokumentation zum Teil schlecht ist, auch bekannt unter der Bezeichnung „Legacy Software“. Ich kann mir gut vorstellen, dass es hier im Grunde passiert ist. Es ist ein Lehrbeispiel, genaugenommen, eines bei dem man sagen kann: „Vorsicht bei solchen Maßnahmen!“ Ich will nicht ausschließen, dass das geht. Aber da muss man sehr sorgfältig arbeiten und möglicherweise zusätzliche Qualitäts– und Sicherheitsmaßnahmen ergreifen, um Kompatibilitätsfehler schon im Design zu erkennen und zu beseitigen.

Wie gesagt, es ist auch nicht ausgeschlossen, dass da wirklich Leute massiv Fehler gemacht haben, aber das kommt im Flugzeugbau äußerst selten vor, weil die Entwicklung unzählige Check-Instanzen durchläuft, einschließlich intensiver Behörden-Reviews. Wenn das doch der Fall sein sollte, dann muss da natürlich eingegriffen werden. Dann müssen auch Köpfe rollen, finde ich, denn das darf nicht sein. Aber wie gesagt, es gab bereits ähnliche Incidents, und da haben Leute vollkommen sorgfältig gearbeitet. Auch den Behörden sind diese Fehlstellen entgangen. Da wurden einfach Kleinigkeiten oder komplizierte Funktionskonstellationen übersehen.

Es sollten immer zwei verschiedene Check-Verfahren bestehen

Ich habe bei kritischen Nachweisen immer mindestens zwei unterschiedliche Check-Verfahren eingesetzt. Und ich kann Ihnen bestätigen: In nicht wenigen Fällen haben wir Diskrepanzen festgestellt, wo ein Checker alleine nicht richtig gearbeitet hat. Oft können Sie die Funktionsweise Ihrer Checker nicht mehr plausibel nachprüfen, beispielsweise beim Model-Checking. Sie können es nur glauben, wenn die melden: „alles OK“. Das ist zu wenig bei kritischen Funktionen. Dann lohnt sich die Investition, den gleichen Nachweis-Schritt nochmal zu machen, mit einem anderen Verfahren, und zu überprüfen: kommen die beide zum gleichen Ergebnis?

Aber muss man eben dann auch als Vorgesetzter in der Lage sein, so eine Zusatzinvestition durchzusetzen. Eine Facility hat mich mal locker 300.000 Dollar gekostet, nur bestimmte kritische Nachweise in einem redundanten Schritt mit dem zweiten dissimilaren Checker zu machen. Das gab damals ein Riesen-Geschrei wegen der Kosten. Aber wenn ich das nicht gemacht hätte, wären bei der Funktionsintegration reihenweise Konfigurationsfehler durchgereicht worden. Das hatte der erste Checker nicht gemerkt. Und angenommen, diese Konfigurationsfehler bewirken kritische Funktionsausfälle, sodass das Flugzeug, sagen wir mal eine Airbus A380, Startverbot erhält. Ein Tag, an dem eine solche Maschine gegroundet ist, kostet eine Million Dollar! Und die zahlt der Flugzeughersteller gemäß Produkthaftung. Gemessen daran heißt das: meine Facility hat sich bereits nach einem Drittel Tag „Aircraft on Ground“ amortisiert gehabt.

Das muss man als Vorgesetzter aber durchsetzen können, dass solche Investition gemacht werden zum Nutzen des Unternehmens. Und das ist, soweit ich sehe, ein Führungsmangel, der heute relativ häufig anzutreffen ist: dass die Vorgesetzten bei solchen Entscheidungen dem Druck des Kapitals, das heißt dem Sparzwang, nicht widerstehen.

Wenn man da überlegt, dass alle 737-MAX-Flugzeuge bereits seit spätestens dem 13. März weltweit gegroundet sind...

Das kostet ein irres Geld, ja. Aber das sieht man auch an anderer Stelle. Nehmen wir mal den Abgasskandal. Das läuft doch auf das Gleiche hinaus. Die konnten die Schadstoffanforderungen zum Start of Production (SOP) nicht ganz erfüllen – OK, kann passieren. Am SOP kommt keiner vorbei, das Produkt muss raus. Dass man dann bei nicht sicherheitskritischen Funktionen mit Software vorübergehend etwas nachhilft – na ja, nicht schön, aber vielleicht verständlich. Nur korrekterweise muss dann sofort ein Vorgesetzter hergehen und zu den Entwicklern sagen: Wir nehmen jetzt eine Million in die Hand, und dann machen wir den Fehler zum nächsten Produktionslos raus. Aber stattdessen haben die acht Jahre lang mit dem gleichen Mist weiter gemacht! Unfassbar!

Das ist einfach Verlust von Integrität, auf den höchsten Führungsebenen. Das kann nicht sein, das darf nicht sein, das sehen sie ja. Irgendwann kommt es raus und dann kostet es das Unternehmen ein irres Geld. Dagegen wären die geschätzte eine Million für das Software Upgrade Projekt Peanuts gewesen. Ich kann nur empfehlen, sich als Unternehmen erst gar nicht auf solche Standpunkte wie beim Abgasskandal einzulassen.

Aber auch wenn im Idealfall nichts passiert, merkt man doch am vorliegenden Fall, wie fatal bei so komplexen Systemen, mit Millionen Zeilen Code, so ein Fehler durchschlagen kann.

Ja. Dramatisch.

Wenn er sich etwas kleines auswirkt und dann, zum Beispiel, nur das Radar anfängt zu flackern, etwas, das die die Piloten es rechtzeitig bemerken und aufgreifen können...?

Das ist kein Problem, dafür gibt es Prozeduren.

Aber wenn sich dann, wie im vorliegenden Fall, etwa das Höhenleitwerk verstellt...

Das ist eine so riesige Fläche, wenn die sich bewegt, das sind unglaubliche aerodynamische Momente die da auftreten. Da kann ich mit dem Ruder so gut wie gar nichts dagegen machen - oder nur mit sehr viel Geschick, wie die Piloten der Interflug Maschine. Da können Sie als Passagier eigentlich nur von Glück sagen, wenn die Flight Crew das wieder fängt. Der Pilot damals, beim A310-Incident, muss Nerven wie Drahtseile gehabt haben.

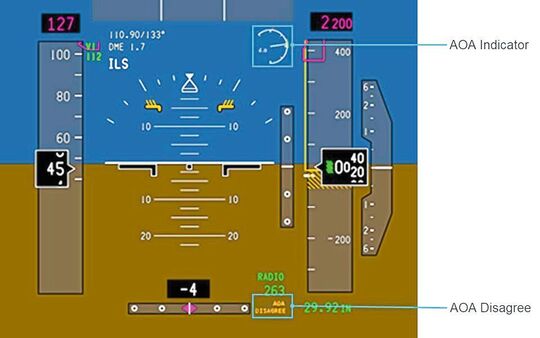

Aber erst einmal in der Panik dann erst einmal einen klaren Gedanken in dieser Richtung fassen, ist ja wieder eine andere Situation. Im vorliegenden Fall kommt ja noch der Vorwurf dazu, dass das nicht ausreichend dokumentiert worden ist, was diese Software genau macht, und ab welchem Höhenwinkel sie jetzt genau anfängt zu greifen.

Dann sind Sie als Pilot so gut wie verloren. Also wenn sie keine System Awareness haben, dann können Sie nur noch mutmaßen. Und wenn dann das falsche Funktionsmodell im Kopf ist, dann hat man keine Chance mehr.

Da merkt man einfach immer wieder wie essentiell auch vernünftige Dokumentation ist.

Absolut.

Und dass man nicht annehmen kann, dass die Funktion von einer solchen Software selbsterklärend ist.

Genau, das ist schon der Punkt. Wenn das System sehr komplex ist, dann muss man ganz besonders sorgfältig sein. In der Dokumentation, und in der Entwicklung. Das muss 100% übereinstimmen und verständlich sein – auch ein Problem der Semantik. Wenn eine Führungskraft da nicht drauf achtet, ihre Entwickler, Prüfer, Dokumentierer und so weiter nicht entsprechend anweist, und versäumt, geeignete Verfahren wie STAMP oder andere formale Methoden einzusetzen – dann ist die Wahrscheinlichkeit, dass etwas übersehen wird, sehr hoch. Und auch, dass das dann zum Konflikt kommt.

:quality(80)/images.vogel.de/vogelonline/bdb/1535300/1535359/original.jpg)

Tod durch Software – Kein Patch kann fatale Fehler wieder richten

:quality(80)/images.vogel.de/vogelonline/bdb/1485200/1485208/original.jpg)

„Software Engineering hat die Aufgabe, sich selbst abzuschaffen“

(ID:45848490)

:quality(80)/p7i.vogel.de/wcms/23/7c/237cae1e646212a6506b57a39f63fdfc/0129206638v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/47/58/4758e91dc6a4ca898787cea68a704d78/0129083411v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e2/a2/e2a20c0d8c4b83ed3a1a97da395aff57/0129071657v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ec/51/ec51ca24a6f5bc18eba4b4365da66db4/0129054296v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f2/de/f2de4f25727ac9ec081ddd044610ba90/0129237486v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f2/cc/f2cceaffbc7eae8ab06d02960b5bd09e/0129216014v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/78/4e787bce78105339f23296c57da438a0/0129197850v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/34/2934d198aa9a6f1da90928486a254e48/0129191183v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/df/72/df72214a59dcab1167187c1dc50ecca2/0129233467v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/03/1d/031dfeb087371f6707f30b46b355e4c0/0129205858v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/6d/656d1dfbd8ed0a8006f645c88bf7b35a/0129137154v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/e7/93e7c549c8a719b3405298b13211a8d3/0129121973v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/68/c368a3ad72ac970809451c311e05a07b/0127817359v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/4f/6a4f63cfca5e01026d25edd19b5302c5/0127761368v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/42/86/4286fd057b5413102fbac1758d2dc55f/0127713923v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/36/49/36496a26b0c295de6d9a36d66ea7571a/0125402418v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/ee/87ee330feb22672271f332405aa5483b/0124869573v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/99/9399c0756dfaeaec3178482561fbf528/0126780481v2.jpeg)